Datamaskin lærte å sjå forskjell på sild og makrell i trålen

Sild, makrell eller noko heilt anna? Det skulle den kunstige intelligensen klara å svara på.

Fotograf: HI

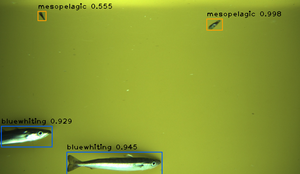

Kolmule (blue whiting) og mesopelagisk fisk blei også identifisert av datamaskina.

Fotograf: HIPublisert: 13.01.2022 Oppdatert: 14.01.2022

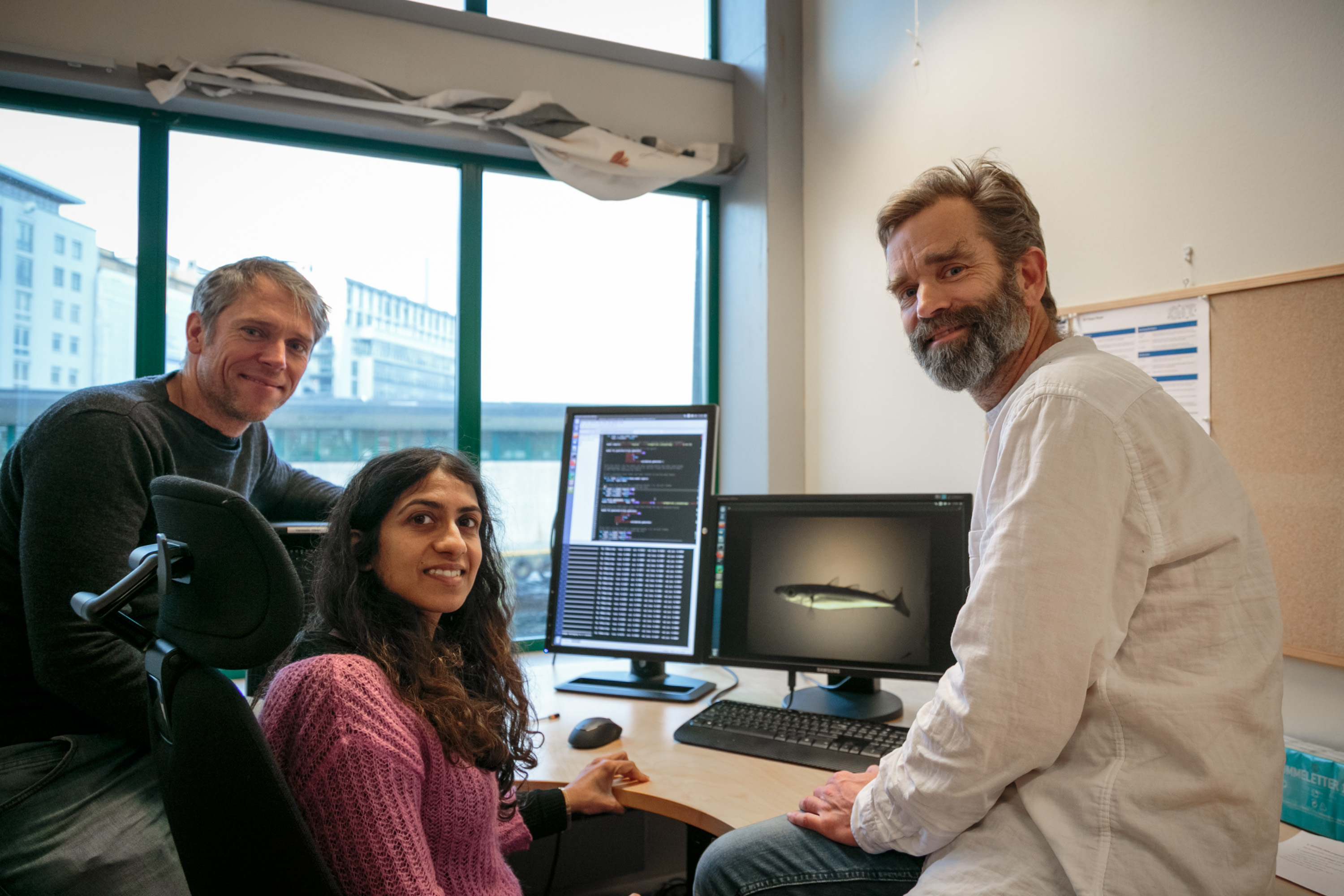

– Automatisk gjenkjenning og teljing av fisk sparer oss for mykje tid og kjedeleg manuelt arbeid, seier forskar Vaneeda Allken ved Havforskingsinstituttet (HI).

Med hjelp av eit kamerasystem i trålen som fotograferer fangsten under fisket kan havforskarane få mykje informasjon som dei elles ikkje ville fått. Blant anna kan dei sjå kor i vassøyla eller trålbanen dei ulike fiskeslaga blir fanga i trålen.

Men om eit menneske skal gå gjennom alle bilda og talt alle fiskane manuelt, ville det kravd enormt mykje arbeid.

Denne utfordringa har Allken og kollegaene no forsøkt å løysa ved hjelp av såkalla djuplæring.

Bestod testen

Djuplæring går ut på at ein datamaskin «lærer» å kjenna igjen mønster i store mengder data gjennom prøving og feiling – ein sentral metode innan kunstig intelligens.

Forskarane brukte eit sett med tusenvis av trålbilde, både ekte og kunstig samansette, til å trena opp den kunstige intelligensen.

Oppgåva var å identifisera fisken på bilda, og seia om det var kolmule, sild, makrell, ein mesopelagisk fisk eller ei blanding av ulike artar. Systemet greier ikkje per i dag å skilja mellom dei mesopelagiske artane laksesild og lysprikkfisk.

Etter «treningsøkta» fekk maskinen bryna seg på eit nytt og ukjent bildesett frå ein trålfangst. Då klarte han å artsbestemma fangsten med ein presisjon på om lag 85 prosent.

Maskinen klarte også å telja kor mykje fisk det var i fangsten totalt.

Kan redusera bifangst

Resultata, som nyleg er publisert i ICES Journal of Marine Science, er eit steg i utviklinga av nye og effektive metodar i havforsking og fiskeriforvalting basert på digital teknologi.

For havforskarane kan det å få bilde frå trålen, automatisk tolka ved hjelp av kunstig intelligens, føra til at dei ikkje treng å ta fisk inn i båten like ofte som i dag.

– Det gjer det mogleg å sjå for oss ei framtid der vi kan bruka trålar med open ende og trekka ut informasjonen vi treng frå bilete i staden for å fanga fisk, seier forskar Vaneeda Allken.

For både forskarar og fiskarar kan teknologien gjera det enklare å sortera fisk av uønskt art eller storleik ut av fangsten.

– Dette vil føra til mindre bifangst, noko som er bra for økosystemet, seier Allken.

Bidrar til viktig innovasjon

Forskar Shale Pettit Rosen, som også bidrog til studien, peikar på at forskinga inngår i ei større satsing ved innovasjonssenteret CRIMAC (sjå faktaboks).

Senteret har som mål å betre og automatisere tolkinga av data frå ekkolodd (akustikk) på forskingsfartøy og fiskebåtar.

– Her trengst det fangstdata for å klassifisere kva ein ser med morgondagens breibandekkolodd, seier Rosen.

– Slike ekkolodd vil i framtida kunna brukast til å driva meir berekraftig fiske, ved å fiske på og fange dei riktige artane og storleikane, og betra fiskeriforvaltinga med ei meir komplett forståing av det marine økosystemet.

Les meir: Har gitt sonaren evne til å beregne hvor mange tonn fisk den ser

Supplement til tradisjonell havforskning

Sjølv om kunstig intelligens avlastar havforskarar for ein del manuelt arbeid, kan ikkje kamera og datamaskiner erstatta gummihanskar og oljeklede.

– Fysiske prøver blir framleis nødvendig for å få informasjon om diett, vekst og kjønn for dei fleste fiskeartane, seier Rosen.

Forskaren peikar også på at kunstig intelligens har sine utfordringar, blant anna i møte med sjeldne artar og andre uventa saker som dukkar opp i trålen.

– Kunstig intelligente system blir gjerne trente med den artssamansetjinga som ein forventar å få i fangsten. Men uføresette objekt, alt frå framande fiskeartar til marint avfall, kan vera viktig å identifisera riktig for å få betre oversikt over økosystemet og endringar i miljøet, seier Rosen.

– Me vil framleis trenga menneske på ulike stadium av forskinga for å sikra at algoritmane fungerer som dei skal og at prediksjonane ikkje bommar systematisk, seier kollega Vaneeda Allken.

Les også: Sjøsatte senter for forskningsinnovasjon med omfattende sildetokt i nord

Referanse:

Allken, Vaneeda, Shale Rosen, Nils Olav Handegard og Ketil Malde. «A deep learning-based method to identify and count pelagic and mesopelagic fishes from trawl camera images». ICES Journal of Marine Science 78, 10 (2021). Lenke: doi.org/10.1093/icesjms/fsab227